推理模型综合测评报告 2025

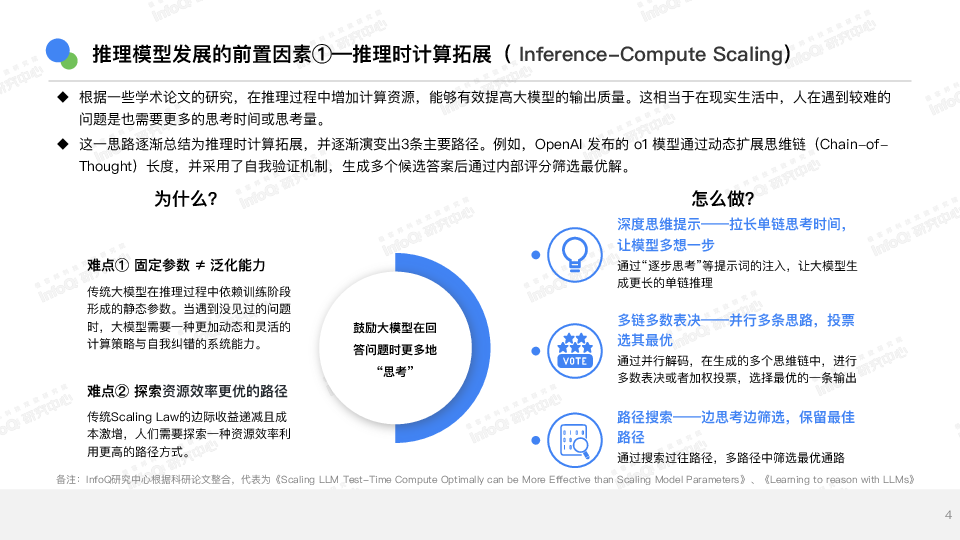

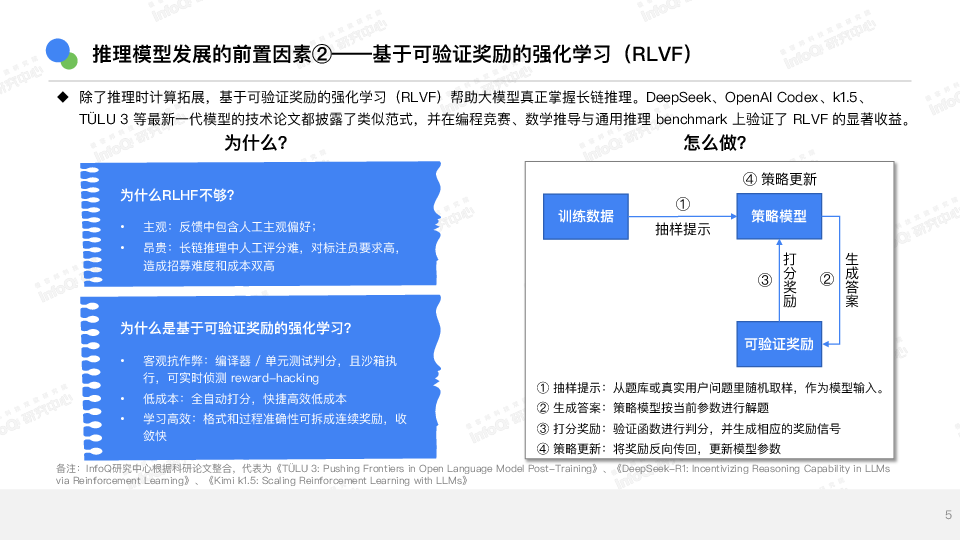

推理理模型综合测评报告2025幻觉控制多步推理理语⾔言推理理逻辑推理理数学推理理⽬目录CONTENT推理理模型发展阶段和发展因素分析01推理理模型测评体系和结果分析02推理理模型未来展望03推理理模型发展阶段和发展因素分析推理理模型发展的前置因素①—推理理时计算拓拓展(Inference-Compute Scaling)u根据⼀一些学术论⽂文的研究,在推理理过程中增加计算资源,能够有效提⾼高⼤大模型的输出质量量。这相当于在现实⽣生活中,⼈人在遇到较难的问题是也需要更更多的思考时间或思考量量。u这⼀一思路路逐渐总结为推理理时计算拓拓展,并逐渐演变出3条主要路路径。例例如,OpenAI发布的o1模型通过动态扩展思维链(Chain-of-Thought)⻓长度,并采⽤用了了⾃自我验证机制,⽣生成多个候选答案后通过内部评分筛选最优解。⿎鼓励⼤大模型在回答问题时更更多地“思考”深度思维提示——拉⻓长单链思考时间,让模型多想⼀一步通过“逐步思考”等提示词的注⼊入,让⼤大模型⽣生成更更⻓长的单链推理理多链多数表决——并⾏行行多条思路路,投票选其最优通过并⾏行行解码,在⽣生成的多个思维链中,进⾏行行多数表决或者加权投票,选择最优的⼀一条输出路路径搜索——边思考边筛选,保留留最佳路路径通过搜索过往路路径,多路路径中筛选最优通路路难点①固定参数≠ 泛化能⼒力力传统⼤大模型在推理理过程中依赖训练阶段形成的静态参数。当遇到没⻅见过的问题时,⼤大模型需要⼀一种更更加动态和灵活的计算策略略与⾃自我纠错的系统能⼒力力。难点②探索资源效率更更优的路路径传统ScalingLaw的边际收益递减且成本激增,⼈人们需要探索⼀一种资源效率利利⽤用更更⾼高的路路径⽅方式。为什什么?怎么做?备注:InfoQ研究中⼼心根据科研论⽂文整合,代表为《Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters》、《Learning to reason with LLMs》4推理理模型发展的前置因素②——基于可验证奖励的强化学习(RLVF)•主观:反馈中包含⼈人⼯工主观偏好;•昂贵:⻓长链推理理中⼈人⼯工评分难,对标注员要求⾼高,造成招募难度和成本双⾼高为什什么RLHF不不够?•客观抗作弊:编译器器

相关推荐

-

鼎帷咨询2025年DeepSeek战略创新分析报告-围绕DeepSeek尖刀点加速打造AI产业刀锋链39页

2025-05-13 19945

2025-05-13 19945 -

新战略咨询2024移动机器人AGV_AMR专用激光雷达产品发展蓝皮书31页

2025-05-15 19948

2025-05-15 19948 -

甲子光年2025年DeepSeeK开启AI算法变革元年报告16页

2025-05-13 19957

2025-05-13 19957 -

CyberRobo2024全球人形机器人产品数据库报告-人形机器人洞察研究BTIResearch99页

2025-05-15 17951

2025-05-15 17951 -

少年商学院2025年DeepSeek中小学生使用手册81页

2025-05-13 19840

2025-05-13 19840 -

英普利集团2025企业出海白皮书中东篇精编版39页

2025-05-14 19542

2025-05-14 19542 -

曼昆律所2024年Web3.0区块链项目出海法律白皮书71页

2025-05-14 18535

2025-05-14 18535 -

火山引擎2024火山引擎视频云实践精选集224页

2025-05-15 18940

2025-05-15 18940 -

2025年无人机生态系统发展计划报告(英文版)-世界银行

2025-06-05 473

2025-06-05 473 -

2025Q1中国企业创投[CVC]发展报告

2025-06-05 310

2025-06-05 310

相关内容

-

甲子光年2025年DeepSeeK开启AI算法变革元年报告16页

分类:机构报告

时间:2025-05-13

标签:

格式:PDF

-

新战略咨询2024移动机器人AGV_AMR专用激光雷达产品发展蓝皮书31页

分类:机构报告

时间:2025-05-15

标签:

格式:PDF

-

鼎帷咨询2025年DeepSeek战略创新分析报告-围绕DeepSeek尖刀点加速打造AI产业刀锋链39页

分类:机构报告

时间:2025-05-13

标签:

格式:PDF

-

少年商学院2025年DeepSeek中小学生使用手册81页

分类:机构报告

时间:2025-05-13

标签:

格式:PDF

-

英普利集团2025企业出海白皮书中东篇精编版39页

分类:机构报告

时间:2025-05-14

标签:

格式:PDF

-

火山引擎2024火山引擎视频云实践精选集224页

分类:机构报告

时间:2025-05-15

标签:

格式:PDF

-

曼昆律所2024年Web3.0区块链项目出海法律白皮书71页

分类:机构报告

时间:2025-05-14

标签:

格式:PDF

-

CyberRobo2024全球人形机器人产品数据库报告-人形机器人洞察研究BTIResearch99页

分类:机构报告

时间:2025-05-15

标签:

格式:PDF

-

中国购车用户家庭存款洞察报告 (2025版)

分类:

时间:2025-07-11

标签:

格式:PDF

-

2025应届生画像白皮书——以AI智略人才模型聚焦应届生新质人才潜能

分类:

时间:2025-07-11

标签:

格式:PDF