张延-DeepSeekR1-MoE-NAS融合赋能领域大模型高效训练体系

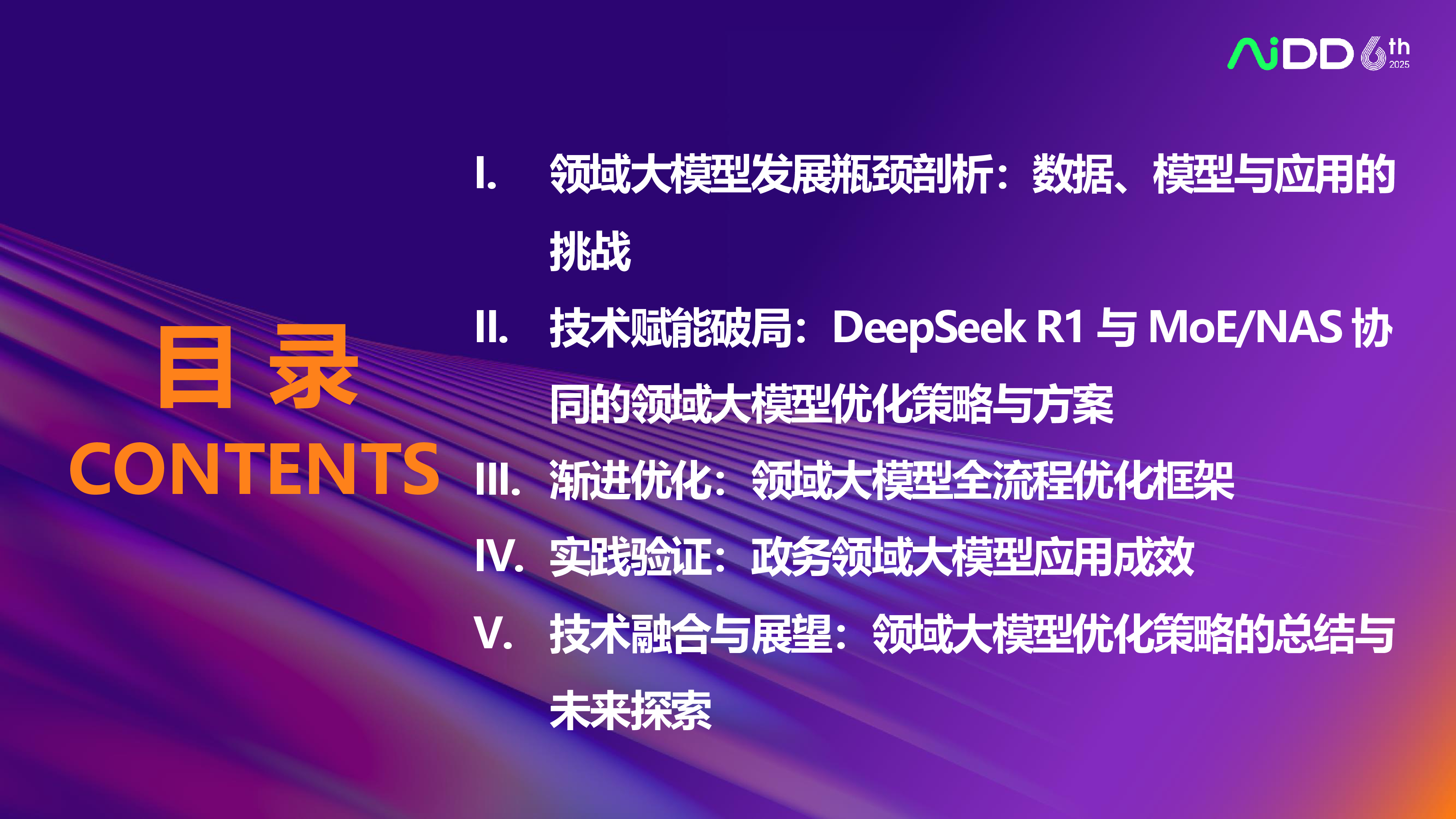

DeepSeek R1-MoE-NAS 融合赋能领域大模型高效训练体系张延 | 联通数字政府产品部张延联通数字政府产品部交付总监现任联通数字科技有限公司数字政府产品部交付总监,拥有高级技术职称。加入中国计算机学会、中国人工智能协会、ACM协会、中国电子学会,并在部分协会中担任职务。深耕人工智能与大数据领域多年,凭借算法优化与技术创新推动企业数据资源整合标准化,为数字化转型提供核心支撑;主导智能应用领域关键系统研发与解决方案落地,助力机构提升运营效率,加速数字化进程并推动行业智能化升级。目 录CONTENTSI.领域大模型发展瓶颈剖析:数据、模型与应用的挑战II.技术赋能破局:DeepSeekR1 与MoE/NAS 协同的领域大模型优化策略与方案III.渐进优化:领域大模型全流程优化框架IV.实践验证:政务领域大模型应用成效V.技术融合与展望:领域大模型优化策略的总结与未来探索领域大模型发展瓶颈剖析:数据、模型与应用的挑战PART 01大模型技术发展浪潮:从奠基到爆发GAN(生成对抗网络)2014AlexNet(ImageNet竞赛冠军)2012ResNet(ILSVRC冠军)2015BERT(Google发布)2018DALL-E(文本生成图像)2021Transformer(Google提出)2017GPT-3(OpenAI发布) 2020GPT-4(多模态大模型)2023DeepSeeK2025架构革命(2017-2018)Transformer与预训练范式奠基期 (2012-2016)深度学习时代的开启爆发期(2020至今)千亿模型与多模态融合模型技术历经三次浪潮:从 AlexNet/ResNet 突破视觉瓶颈开启深度学习时代,到 Transformer/BERT 重构 NLP 范式,最终在 GPT-3/DALL-E 等千亿参数模型推动下实现多模态融合与通用智能演进,持续突破算力效率与模型泛化能力边界。这场技术革命正加速重塑人类社会。 随着 GPT-4 等万亿参数模型涌现,AI 从工具属性向协作主体演进,通过开源生态共建共享,或将成为驱动科学发现、产业升级与社会治理的通用基础设施,在伦理框架与技术创新的动态平衡中,开启人机协同的文明新纪元。领域模型的必要性:从通用性到精准性的跨越 当今人工智能发展,从通用性迈向精准性是关键趋势。大模型通用性强,但在垂直领域存挑

相关推荐

-

鼎帷咨询2025年DeepSeek战略创新分析报告-围绕DeepSeek尖刀点加速打造AI产业刀锋链39页

2025-05-13 19940

2025-05-13 19940 -

新战略咨询2024移动机器人AGV_AMR专用激光雷达产品发展蓝皮书31页

2025-05-15 19947

2025-05-15 19947 -

甲子光年2025年DeepSeeK开启AI算法变革元年报告16页

2025-05-13 19955

2025-05-13 19955 -

CyberRobo2024全球人形机器人产品数据库报告-人形机器人洞察研究BTIResearch99页

2025-05-15 17949

2025-05-15 17949 -

少年商学院2025年DeepSeek中小学生使用手册81页

2025-05-13 19839

2025-05-13 19839 -

英普利集团2025企业出海白皮书中东篇精编版39页

2025-05-14 19541

2025-05-14 19541 -

曼昆律所2024年Web3.0区块链项目出海法律白皮书71页

2025-05-14 18533

2025-05-14 18533 -

火山引擎2024火山引擎视频云实践精选集224页

2025-05-15 18939

2025-05-15 18939 -

2025年无人机生态系统发展计划报告(英文版)-世界银行

2025-06-05 472

2025-06-05 472 -

2025Q1中国企业创投[CVC]发展报告

2025-06-05 307

2025-06-05 307

相关内容

-

甲子光年2025年DeepSeeK开启AI算法变革元年报告16页

分类:机构报告

时间:2025-05-13

标签:

格式:PDF

-

新战略咨询2024移动机器人AGV_AMR专用激光雷达产品发展蓝皮书31页

分类:机构报告

时间:2025-05-15

标签:

格式:PDF

-

鼎帷咨询2025年DeepSeek战略创新分析报告-围绕DeepSeek尖刀点加速打造AI产业刀锋链39页

分类:机构报告

时间:2025-05-13

标签:

格式:PDF

-

少年商学院2025年DeepSeek中小学生使用手册81页

分类:机构报告

时间:2025-05-13

标签:

格式:PDF

-

英普利集团2025企业出海白皮书中东篇精编版39页

分类:机构报告

时间:2025-05-14

标签:

格式:PDF

-

火山引擎2024火山引擎视频云实践精选集224页

分类:机构报告

时间:2025-05-15

标签:

格式:PDF

-

曼昆律所2024年Web3.0区块链项目出海法律白皮书71页

分类:机构报告

时间:2025-05-14

标签:

格式:PDF

-

CyberRobo2024全球人形机器人产品数据库报告-人形机器人洞察研究BTIResearch99页

分类:机构报告

时间:2025-05-15

标签:

格式:PDF

-

中国购车用户家庭存款洞察报告 (2025版)

分类:

时间:2025-07-11

标签:

格式:PDF

-

2025中国低空经济市场现状报告

分类:

时间:2025-07-11

标签:

格式:PDF